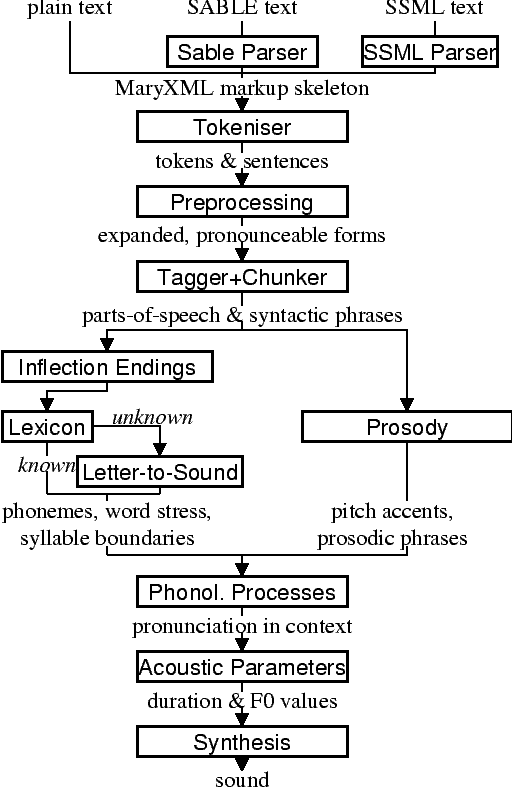

| Abbildung 9.1: | Architektur von MARY-TTS-System |

[ Weiter ] [ Seitenende ] [ Überkapitel ] [ Bitte Skript-Fehler melden ]

Sprachsynthesesysteme ▸▸▸

Definition 9.1.1 (Text-To-Speech System, TTS). Ein Sprachsynthesesystem erzeugt aus einer Zeichenkette (Text) ein akustisches Signal.

Die Spracherzeugung setzt eine mehr oder weniger tiefe linguistische Textanalyse voraus.

Beispiel 9.1.2 (Ein deutscher Stolpersatz).

“Dr. A. Smithe von der NATO (und nicht vom CIA) versorgt z.B. - meines Wissens nach - die Heroin

seit dem 15.3.00 tgl. mit 13,84 Gramm Heroin zu 1,04 DM das Gramm.”

Qualitätsmerkmale für Sprachsynthese

Weiteres

Unterschiedliche Benutzer haben unterschiedliche Bedürfnisse. Blinde Personen schätzen es, wenn das Sprechtempo stark erhöht werden kann.

Einsatzmöglichkeiten von Sprachsynthese

Typische Architektur von TTS

Vom der Zeichenkette zum Laut

Beispiel-Architektur von MARY TTS

Aussprache von Ziffern und Abkürzungen

Die Aussprache von Ziffernotationen variiert vielfältig innerhalb einer Sprache und zwischen

Kulturräumen [Liberman und Church 1992].

Beispiel 9.1.3 (Varianten im Deutschen).

Frage

Welche Aussprachen sind für welche Grössen verbreitet?

Probleme bei Abkürzungen

Welche Schwierigkeiten stellt die Aussprache von Abkürzungen?

Phonetische Analyse: Lautfolgen und Akzente von Wörtern

Wie werden die einzelnen Laute eines Wortes in Isolation repräsentiert?

Definition 9.1.4 (Pronunciation Dictionary). Ein elektronisches Aussprachewörterbuch enthält für (flektierte) Wortformen oder Grundformen eine Repräsentation der Lautform (Lautfolge, Akzente) in einer Lautschrift.

Z.B. in Form der Revision 2005 des International Phonetic Alphabet (IPA) http://www.langsci.ucl.ac.uk/ipa, bzw. einer auf Computern einfacher verwendbareren Kodierung davon.

Beispiel 9.1.5 (Formate elektronischer Aussprachewörterbücher nach [Jurafsky und Martin 2000]).

IPA-Lautschrift für Deutsch

Vgl. volles IPA in [Carstensen et al. 2009, 213])

Phonetische Lautschrift (SAMPA German)

Eine in ASCII kodierte Notationsvariante für IPA-Symbole.

Frage

Wie kann man das Wort “jenseits” schreiben?

Hinweis: Das Wiktionary für Deutsch http://de.wiktionary.org ist auch ein Aussprachewörterbuch.

Phonologische Analyse

Welche Gesetzmässigkeiten der gegenseitigen Beeinflussung von Lauten in ihrem (aus-)sprachlichen

Kontext gelten?

Definition 9.1.6 (Phonological Rules). Phonologische Regeln spezifizieren die Umstände, unter denen phonologische Alternationen statt finden.

Die Zwei-Ebenen-Morphologie bietet eine praktische Modellierung und Implementation dafür an.

Beispiel 9.1.7 (Phonologische Alternationen).

Das Plural-s wird im Englischen je nach Umgebung ganz unterschiedlich ausgesprochen: “peaches”,

“pigs”, “cats”.

Morphologie und Ausspracheregeln

Ausspracheregeln beziehen sich nicht auf das Wort, sondern auf Morphe

(Vorsilben, Endungen, Wortstämme).

Beispiel 9.1.8 (Aussprache von „st“).

Wann wird in deutschen Wörtern „st“ als [ʃt] und wann als [st] ausgesprochen? Beispiele: Lastwagen,

staunen, bestaunen, Staubsauger, Feinstaub, Krebstest, zurückkrebste

Beispiel 9.1.9 (Auslautverhärtung).

Im Deutschen werden gewisse Laute entstimmlicht, wenn sie am Ende eines Morphs stehen und nicht

vor einem Vokal. „Krug“ → [’kru:ɡ]→ [’kru:k] „Krug+s“ → [’kru:ɡ]+[s] → [’kru:ks] „Krug+es“ →

[’kru:ɡ]+[əs] → [’kru:ɡəs]

Probleme der morphologischen Analyse und Lautfolgenberechnung

Prosodische Analyse: Akzentuierung im Wort

Definition 9.1.10 (Wortakzent). Der Wortakzent ist diejenige Silbe eines Worts, welche am stärksten betont wird.

Regelhaftigkeit von Wortakzenten im Deutschen

Die Nebenakzente können immer durch Fokusakzentuierung semantisch/pragmatisch zum stärksten Akzent gemacht werden.

Prosodische Analyse: Phrasen und Sätze

Um Satzintonation (Prosodie) korrekt wiederzugeben, braucht es teilweise detaillierte linguistische

Analysen.

Beispiel 9.1.11 (Satzintonation und -rhythmus).

The rear aggregate pumps …

Beispiel 9.1.12 (Satzbetonung und Pausen).

Grundregel der Phrasierung

Eine Phrasengrenze zwischen 2 benachbarten Wörtern ist umso plausibler, je stärker die Wörter in der syntaktischen Struktur getrennt sind voneinander.

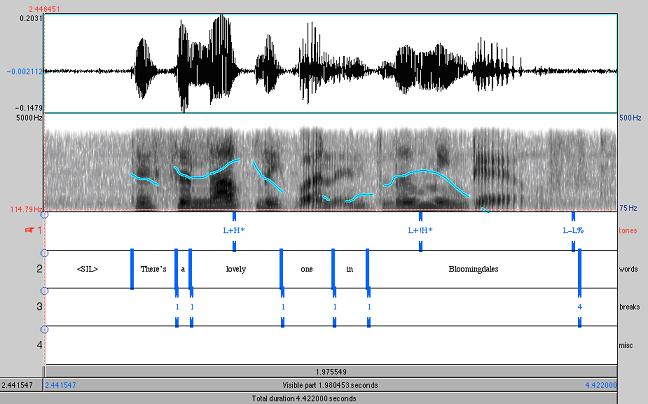

Was ist Prosodie auf Satzebene? [Bader 2006]

Pausen und Satzbetonung sind an der Amplitude der Schallwellen ablesbar. Der Grundfrequenzverlauf

(oft mit f0 bezeichnet) gibt die relativen Tonhöhenunterschiede in der gesprochenen Sprache wieder.

Ein frei verfügbares Tool, um die verschiedenen akustischen Aspekte der Sprache auf dem Computer zu analysieren, ist unter http://www.praat.org zu finden.

Prosodie: ToBI-Modell (Tones and Break Indices)

Beispiel: Prosodie [Simmons 2006b]

Quelle: http://anita.simmons.edu/~tobi/chap2-7/chapter2-7.htm

| Abbildung 9.4: | Satzintonation mit ToBi-Annotierung (Hörbeispiel: [Simmons 2006a]) |

Prosodiesteuerung

Aus der phonologische Analyse (Laute, Akzente, Pausen, Tonhöhenverlauf) werden die prosodischen Parameter der Laute für die Sprachsynthese berechnet: Dauer, Grundfrequenz, Intensität . Die Verwendung der klassischen linguistischen Einheit Phonem (35-50 pro Sprache) für Sprachgenerierung ergibt keine guten Systeme.

Wie lassen sich natürlichere und fliessende Übergänge der Laute erzeugen?

Definition 9.1.13 (Diphone ▸▸▸). Ein Diphon geht von der Mitte eines Phonems zur Mitte des nächsten Phonems. Für Deutsch kommt man etwa auf 2’500 existierende Diphone, für Spanisch auf 800.

Koartikulation von Lauten wird dadurch auf jeweils 2 Phonemkombinationen beschränkt. In der Phonemmitte ist das menschliche Gehör weniger empfindlich auf Unebenheiten.

Sprachsignalproduktion: Sprachkonserven

Am primitivsten funktioniert Sprachsynthese, wenn ganze Wörter oder Teilsätze als akustische

Sprachkonserven nacheinander ausgegeben werden.

Dies funktioniert für eingeschränkte Anwendungsgebiete: "Jetzt. Bitte. Rechts. Abbiegen."

Beispiel 9.1.14 (Ein Problem zu einfacher Ansätze).

Unit Selection Databases

Ein Weiterentwicklung sind grosse Datenbanken, welche unterschiedlich grosse Einheiten (Diphone, Phone, Silben, Wörter) umfassen und eine optimale Selektion daraus versuchen.

Speech Synthesis Markup Language (SSML)

Dieser XML-Standard erlaubt eine strukturierte Spezifikation von verschiedenen Parametern einer

Speech-Applikation.

http://www.w3.org/TR/2004/REC-speech-synthesis-20040907/

[ Weiter ] [ Seitenbeginn ] [ Überkapitel ] [ Bitte Skript-Fehler melden ]