| Truth | |||

| Pos | Neg | ||

| Test | Pos | TP | FP

|

| Neg | FN | TN

| |

| Tabelle 6.4: | Recall |

[ Zurück ] [ Zurück (Seitenende) ] [ Seitenende ] [ Überkapitel ] [ Bitte Skript-Fehler melden ]

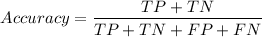

Evaluation von binären Klassifikatoren

| Truth | |||

| Positive | Negative | ||

| Test | Positive | True Positive (TP) | False Positive (FP)

|

| Negative | False Negative (FN) | True Negative (TN)

| |

| Tabelle 6.3: | Schema zum Abgleich von Test-Klassifikator und Wahrheit |

Legende zur Tabelle ???

Problem der Fehlerabschätzung I

Beispiel 6.5.1 (FP: Fehlertyp I). Ein syntaktischer Test zur Identifizierung einer seltenen Konstruktion, welche nur in 1 von 100’001 Sätzen auftaucht, findet zwar alle vorhandenen Konstruktionen, liefert aber leider 1% Falsch-Positive. D.h die Korrektheit (accuracy) ist 99%.

Wie wahrscheinlich ist es, dass der Test tatsächlich eine gesuchte Konstruktion gefunden hat, wenn er ein positives Resultat vermeldet?

Man überlege:

Wie oft wird ein positives Testresultat bei 100’001 Sätzen gemeldet? Wieviele TP sind im Schnitt darunter?

Problem der Fehlerabschätzung II

Beispiel 6.5.2 (FN: Fehlertyp II). Ein syntaktischer Test zur Identifizierung einer häufigen Konstruktion, welche in 80’000 von 100’000 Sätzen auftaucht, findet 12.5% der Fälle nicht, produziert jedoch keine falschen Treffer.

Wie wahrscheinlich ist es, dass ein Satz die Konstruktion trotzdem enthält, obwohl der Test ein negatives Resultat vermeldet?

Man überlege:

Wie oft wird ein negatives Testresultat bei 100’000 Sätzen gemeldet? Wieviele FN sind darunter?

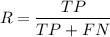

Dualität von Precision und Recall

| Truth | |||

| Pos | Neg | ||

| Test | Pos | TP | FP

|

| Neg | FN | TN

| |

| Tabelle 6.4: | Recall |

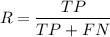

| Truth | |||

| Pos | Neg | ||

| Test | Pos | TP | FP

|

| Neg | FN | TN

| |

| Tabelle 6.5: | Precision |

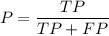

| Truth | |||

| Pos | Neg | ||

| Test | Pos | TP | FP

|

| Neg | FN | TN

| |

| Tabelle 6.6: | F1-Measure |

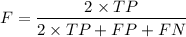

| Truth | |||

| Pos | Neg | ||

| Test | Pos | TP | FP

|

| Neg | FN | TN

| |

| Tabelle 6.7: | Accuracy |

F-Measure: Harmonisches vs. arithmetisches Mittel

[ Zurück ] [ Zurück (Seitenende) ] [ Seitenbeginn ] [ Überkapitel ] [ Bitte Skript-Fehler melden ]