Definition 5.3.1. Recall

gibt den Anteil der korrekt gefundenen Chunks gemessen an allen möglichen korrekten Chunks

an.

[ Weiter ] [ Zurück ] [ Zurück (Seitenende) ] [ Seitenende ] [ Überkapitel ]

Recall (Ausbeute, Abdeckung, Vollständigkeit)

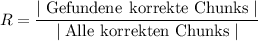

Definition 5.3.1. Recall

gibt den Anteil der korrekt gefundenen Chunks gemessen an allen möglichen korrekten Chunks

an.

Beispiel 5.3.2 (Recall eines Chunkers).

Ein Chunker hat von 800 vorhandenen NPs in einem Testkorpus 600 korrekt als NP klassifiziert.

At = 600 und Nt = 800. Der Recall berechnet sich als: R =  = 75%

= 75%

Precision (Genauigkeit, Präzision)

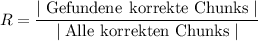

Definition 5.3.3. Precision

gibt den Anteil der korrekt gefundenen Chunks gemessen an allen gefundenen Chunks.

Beispiel 5.3.4 (Precision eines Chunkers).

Ein Chunker hat in einem Testkorpus 1’000 Chunks als NP klassifiziert, aber nur 600 davon waren

tatsächlich NP.

At = 600 und A = 1000. Die Precision berechnet sich als: P =  = 60%

= 60%

F-Score oder F-Measure (F-Mass)

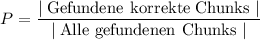

Definition 5.3.5 (F1-Measure). Das F-Measure

verrechnet Precision und Recall gleichgewichtet zum harmonischen Mittelwert.

Formal: Sei P die Precision und R der Recall eines Systems:

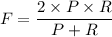

Beispiel 5.3.6 (F-Mass eines Chunkers).

Ein Chunker hat in einem Testkorpus eine Präzision von 60% und ein Recall von 75% für NPs.

Das F-Measure berechnet sich somit: F =  = 66.6%

= 66.6%

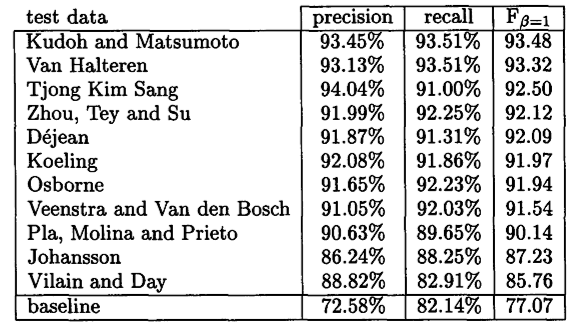

Resultate der Chunking-Shared-Task der CoNLL 2000

| Abbildung 5.5: | Resultate der Chunking-Shared-Task der CoNLL 2000 [Tjong Kim Sang und Buchholz 2000, 131] |

[ Weiter ] [ Zurück ] [ Zurück (Seitenende) ] [ Seitenbeginn ] [ Überkapitel ]